视频生成模型作为世界模拟器.

大多数现有的视频生成模型通常只关注短视频或固定尺寸的视频生成。这项工作探索了视频数据上的生成模型大规模训练,在不同时长、分辨率和长宽比的视频和图像上训练了基于Transformer的文本条件扩散模型Sora,能够生成一分钟左右的高保真度视频。

Sora把所有类型的视觉数据(视频、图像)表示为patch token,通过这种统一的表示实现模型的大规模训练。作者发现patch token对于在各种视觉数据上训练的生成模型是一种高度可扩展和高效的表示。Sora首先把视频压缩到低维隐空间,然后把特征拆分成时空patch。

视频压缩网络接收原视频作为输入,输出在时序和空间尺寸上都经过压缩的隐藏表示。Sora的训练和生成都是在这个压缩后的隐空间上进行的。同时训练一个解码器模型用于把隐表示解码回像素空间。

Sora是一种Transformer结构的扩散模型,给定输入随机patch和文本等条件信息,通过训练来预测原始的图像patch。

给定压缩后的输入视频或图像,将其提取为一个时空patch序列,进一步作为Transformer的输入token。这种基于patch的表示允许Sora使用不同时长、分辨率和长宽比的视频和图像进行训练;在推理时,通过在指定尺寸的网格中排列随机初始化的patch能够控制输出视频的尺寸。

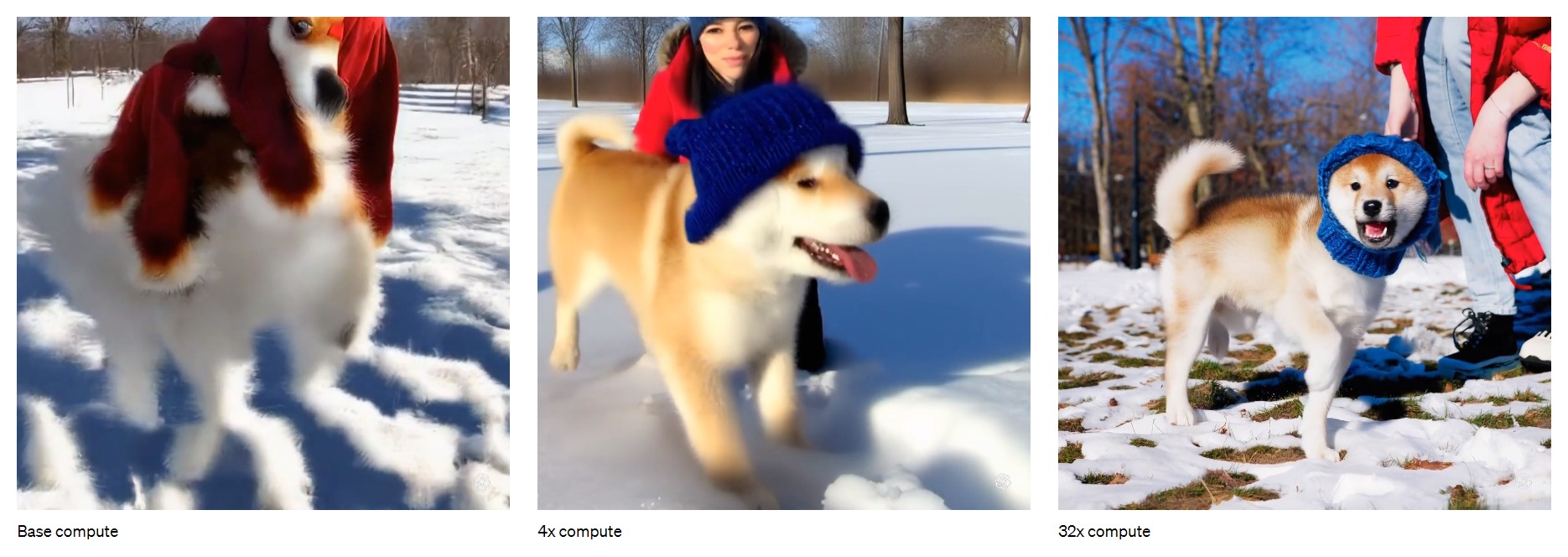

受益于Transformer结构,Sora具有模型可扩展性。随着训练成本的增加,视频的生成质量显著提高。

Sora可以生成任意尺寸的视频,因此可以直接按照不同设备的固定长宽比来创作内容,还可以以较小的分辨率对所需要生成的视频进行快速原型化。

作者经验性地发现按照原视频的固有尺寸进行训练能够改善视频的压缩质量和连续帧质量。作为对照,把视频尺寸全部调整为正方形后训练一个模型,该模型生成的视频有时仅包含一部分视角。

为了构造大量的视频-文本对,作者使用DALL·E进行视频re-captioning,即首先训练一个高度描述性的图像描述模型,然后使用它为训练集中的所有视频添加文本描述。对图像描述模型的训练可以提高文本保真度以及视频的整体质量。与DALL·E 3类似,作者还利用GPT将用户输入的简短文本提示转换为较长的文本描述并发送到视频生成模型,从而能够准确地按照用户提示生成高质量的视频。

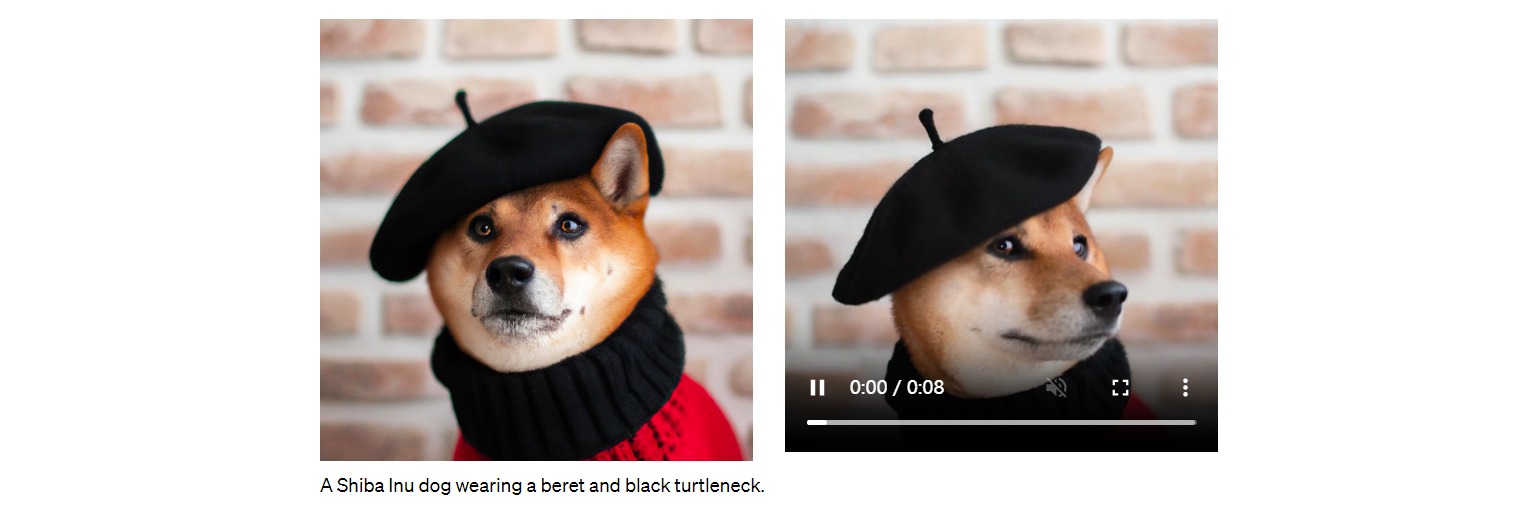

Sora不仅能够接收文本作为条件输入,还可以接收图像或者视频作为条件,并基于此进行图像或视频的编辑任务,如创建完美循环的视频、为静态图像设置动画、在时间上向前或向后扩展视频等。

Sora还可以在两个输入视频之间逐渐插值,从而在两个完全不同主题和场景组成的视频之间创建无缝过渡。

Sora在大规模训练时表现出能够从物理世界模拟人、动物和环境的某些特性。这些特性的出现没有任何明显的归纳偏差,纯粹是模型的尺度现象。

- 3D一致性:可以生成跟随动态相机运动的视频。随着相机的移动和旋转,场景中的元素可以在三维空间中一致地移动。

- 远距离连贯性和物体持久性:能够有效地对短期和长期依赖关系进行建模。例如可以持久化物体,即使它们被遮挡或离开视角。并且可以在单个视频中生成同一角色的多个镜头,并在整个视频中保持其外观。

- 与环境交互:可以用简单的方式模拟影响世界状态的动作。例如一个画家在画布上留下新的画痕,或者一个男人吃汉堡并留下咬痕。

- 模拟数字世界:能够模拟人工过程,例如电子游戏。例如用一个基本策略同时控制《我的世界》中的玩家,同时也可以高保真地渲染世界。

这些能力表明,可扩展的视频生成模型是开发物理和数字世界以及生活在其中的物体的高效模拟器。

Sora目前作为一个模拟器表现出许多局限性。例如,它不能准确地模拟许多相互作用的物理过程,比如玻璃破碎。并不总是能体现物体状态的正确变化。此外还有较长时间的视频中出现的不相干现象。